Bạn đã sẵn sàng “đánh cắp” sức mạnh của các mô hình ngôn ngữ lớn (LLM) trên AWS Bedrock, rồi “trộn” thêm một chút Retrieval‑Augmented Generation (RAG) và Agentic AI để tạo ra siêu trợ lý AI “độc lập”? Hãy cùng daileit khám phá hành trình đầy hài hước nhưng không kém phần chi tiết này – từ việc mở tài khoản AWS cho tới khi mô hình của bạn tự mình đi mua cà phê cho người dùng. Bài viết sẽ vượt qua 700 từ, vì ai mà muốn đọc một bài “ngắn gọn” khi có thể “đồ ăn thừa” cho trí não?

1. AWS Bedrock là gì? (Không, không phải là đá nền cho giường ngủ)

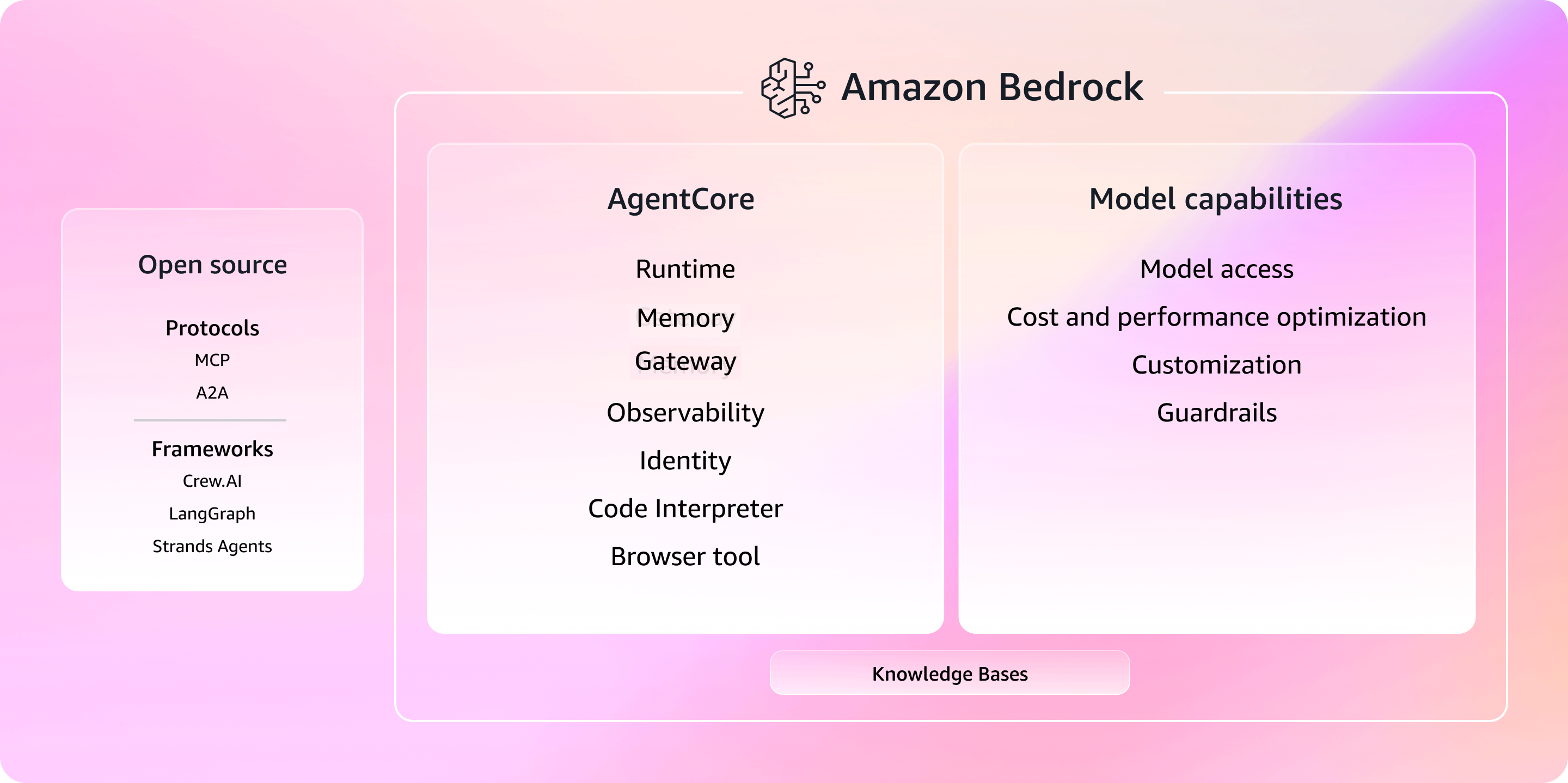

AWS Bedrock là dịch vụ “điện tử” của Amazon cho phép bạn tạo, đào tạo và triển khai các mô hình LLM mà không cần phải tự mình xây dựng hạ tầng siêu phức tạp. Nó giống như một bếp ăn nhanh: bạn chỉ cần chọn “menu” (mô hình), đặt “đặt hàng” (cấu hình) và chờ “đồ ăn” (kết quả) xuất hiện. Đặc biệt, Bedrock tích hợp sẵn các mô hình nổi tiếng như Claude, Jurassic‑2, và Llama 2, giúp bạn không phải “đào mỏ” dữ liệu từ đầu.

2. Tại sao lại “phối” LLM với RAG và Agentic AI?

- LLM: Đọc và viết như con người, nhưng đôi khi “đánh mất” thực tế.

- RAG (Retrieval‑Augmented Generation): Khi LLM “đánh rơi” thông tin, RAG sẽ “cầm tay” đưa dữ liệu thực tế từ nguồn bên ngoài (cơ sở dữ liệu, tài liệu, web) vào để “điều chỉnh” câu trả lời.

- Agentic AI: Đưa cho mô hình khả năng “tự quyết định” – không chỉ trả lời mà còn thực hiện hành động (gửi email, cập nhật CRM, thậm chí đặt pizza).

Kết hợp ba yếu tố này, bạn sẽ có một “siêu trợ lý” không chỉ biết nói mà còn biết làm – và không quên “đùa” một chút để người dùng cảm thấy thân thiện.

3. Chuẩn bị “đồ dùng” – Những thứ không thể thiếu

- Tài khoản AWS: Đăng ký (hoặc dùng tài khoản hiện có). Đừng quên bật Billing Alerts để tránh “bùng nổ” chi phí.

- AWS CLI & SDK: Cài đặt

awsclivàboto3(Python). Nếu bạn thích “cầm tay” hơn, có thể dùng AWS CloudShell trực tiếp trên console. - Python 3.9+ và virtual environment: Để quản lý các thư viện như

transformers,langchain,faiss-cpu(hoặcfaiss-gpunếu bạn có GPU). - Kho dữ liệu cho RAG: Có thể là S3 bucket chứa PDF, CSV, hoặc một Elasticsearch domain.

- IAM Role với quyền

bedrock:InvokeModel,s3:GetObject, vàes:ESHttpGet(nếu dùng Elasticsearch).

4. Bước 1 – “Mở cửa” AWS Bedrock

Đăng nhập vào AWS Management Console, tìm “Bedrock” trong mục Machine Learning. Nếu lần đầu, bạn sẽ thấy một màn hình “Welcome to Bedrock – Let’s build something amazing!”. Nhấn Get started, sau đó:

- Chọn Model Provider (Claude, Jurassic‑2, Llama 2…). Đối với ví dụ này, mình sẽ dùng Llama 2‑13B vì nó “đủ mạnh” nhưng không “đắt đỏ”.

- Đặt tên mô hình:

daileit‑llm‑rag‑agent. - Chọn Instance Type:

ml.g5.xlarge(GPU) nếu bạn muốn tốc độ “đánh bại” chợ, hoặcml.c5.largecho ngân sách “hẹp”. - Nhấn Create model và chờ vài phút để AWS chuẩn bị môi trường.

5. Bước 2 – Xây dựng “Thư viện tri thức” cho RAG

RAG cần một “kho lưu trữ” để tìm kiếm thông tin. Hai cách phổ biến:

5.1 S3 + FAISS (đơn giản, phù hợp cho dự án nhỏ)

- Upload tài liệu (PDF, TXT, CSV) lên S3 bucket

daileit‑rag‑bucket. - Viết script Python để:

- Đọc file từ S3 (bằng

boto3). - Chuyển đổi nội dung thành embedding bằng mô hình LLM (hoặc mô hình embedding riêng như

sentence‑transformers/all‑mpnet‑base‑v2). - Lưu embeddings vào FAISS index (có thể lưu dưới dạng

.indextrên S3).

- Đọc file từ S3 (bằng

- Khi người dùng hỏi, bạn sẽ:

- Chuyển câu hỏi thành embedding.

- Tra cứu top‑k tài liệu gần nhất trong FAISS.

- Gửi các đoạn văn bản này kèm theo prompt tới LLM để “tái tạo” câu trả lời.

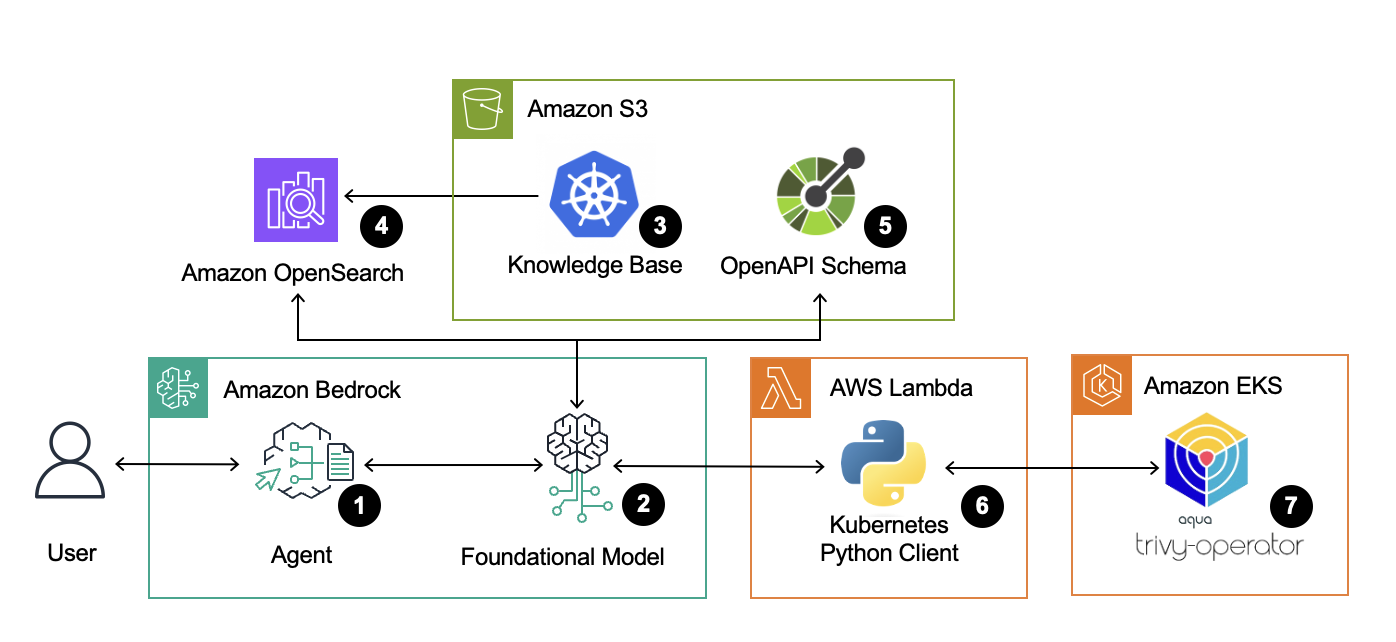

5.2 Amazon OpenSearch (Elasticsearch) – Khi dữ liệu “cực lớn”

- Tạo OpenSearch domain

daileit‑rag‑search(chọn instance t2.medium cho thử nghiệm). - Index tài liệu bằng

_bulkAPI, kèmvectorfield chứa embedding. - Sử dụng

knnquery để tìm kiếm tài liệu tương đồng.

6. Bước 3 – “Thêm bộ não” Agentic AI

Agentic AI không phải là một mô hình mới, mà là cách “đóng gói” LLM với các công cụ (tool) để thực hiện hành động. Chúng ta sẽ dùng LangChain – một framework “điều khiển” LLM như một người trợ lý đa nhiệm.

- Install LangChain và các plugin:

pip install langchain[all] boto3 - Định nghĩa Toolset:

SearchTool: Gọi OpenSearch để lấy tài liệu.EmailTool: Sử dụngAmazon SESđể gửi email.TodoTool: Ghi chú vào DynamoDB.

- Tạo Agent:

from langchain.agents import initialize_agent, Tool

from langchain.llms import BedrockLLM

llm = BedrockLLM(model_id="meta.llama2-13b")

tools = [

Tool(name="Search", func=search_func, description="Tìm kiếm thông tin trong kho dữ liệu."),

Tool(name="SendEmail", func=send_email_func, description="Gửi email tới người dùng."),

Tool(name="AddTodo", func=add_todo_func, description="Thêm công việc vào danh sách Todo.")

]

agent = initialize_agent(tools, llm, agent_type="zero-shot-react-description") - Khi người dùng hỏi: “Bạn có thể tìm cho mình báo cáo Q3 và gửi email cho trưởng phòng không?”, agent sẽ:

- Gọi

SearchToolđể lấy báo cáo. - Dùng

SendEmailToolđể gửi file đính kèm. - Trả lời người dùng “Đã gửi xong, chúc bạn một ngày làm việc hiệu quả!”

- Gọi

7. Bước 4 – Đào tạo “tinh tế” (Fine‑tuning) nếu cần

Bedrock cho phép bạn “fine‑tune” mô hình với dữ liệu riêng (định dạng JSONL). Quy trình:

- Chuẩn bị dataset:

{"prompt": "...", "completion": "..."}– ví dụ, các câu hỏi thường gặp trong doanh nghiệp. - Upload dataset lên S3 bucket

daileit‑fine‑tune. - Sử dụng AWS CLI:

aws bedrock start-fine-tuning-job \

--model-id meta.llama2-13b \

--training-data-s3-uri s3://daileit-fine-tune/dataset.jsonl \

--output-s3-uri s3://daileit-fine-tune/output/ - Giám sát tiến trình qua console hoặc

aws bedrock describe-fine-tuning-job. - Khi hoàn thành, tạo một endpoint mới cho mô hình đã fine‑tuned và cập nhật

model_idtrong code Agent.

8. Bước 5 – Kiểm thử và “đánh giá” (Testing & Evaluation)

Đừng để mô hình “đi làm” mà không kiểm tra! Một số bước kiểm thử:

- Unit tests cho mỗi tool (Search, Email, Todo) – dùng

pytestvàmotođể mock AWS services. - End‑to‑end test bằng cách gửi một chuỗi câu hỏi qua API Gateway → Lambda (nơi chạy Agent) và kiểm tra phản hồi.

- Metrics: Đo latency, cost per request, và accuracy (sử dụng BLEU hoặc ROUGE so với đáp án chuẩn).

9. Bước 6 – Đưa vào Production (Deploy)

- API Gateway + Lambda: Tạo một endpoint RESTful, Lambda sẽ khởi tạo Agent và trả về kết quả.

- Container (ECS/Fargate): Nếu bạn muốn kiểm soát môi trường hơn, đóng gói code vào Docker và chạy trên Fargate.

- Monitoring: Dùng CloudWatch Logs, Metrics, và X‑Ray để theo dõi lỗi, thời gian phản hồi và chi phí.

- Cost Optimization: Đặt Provisioned Concurrency cho Lambda hoặc Auto Scaling cho ECS để tránh “đốt tiền” khi không cần.

10. Một vài “bẫy” thường gặp (Pitfalls) – Đừng để chúng “đánh bại” bạn

- Quá tin tưởng vào LLM: LLM có thể “bịa chuyện”. Luôn dùng RAG để kiểm chứng dữ liệu quan trọng.

- Chi phí không kiểm soát: Mô hình lớn + RAG + Agentic AI = chi phí “bùng nổ”. Đặt budget alerts và sử dụng spot instances nếu có thể.

- Quyền truy cập IAM quá rộng: Chỉ cấp quyền cần thiết cho mỗi service (nguyên tắc “least privilege”).

- Latency cao khi truy vấn RAG: Tối ưu hoá FAISS index (IVF, PQ) hoặc dùng OpenSearch KNN để giảm thời gian tìm kiếm.

Kết luận – Bạn đã sẵn sàng “đi làm” chưa?

Triển khai một mô hình LLM trên AWS Bedrock, “trộn” RAG để cung cấp thông tin chính xác và “đánh bại” bằng Agentic AI để thực hiện hành động thực tế không còn là chuyện khoa học viễn tưởng. Với các bước chi tiết trên, bạn có thể biến ý tưởng “AI trợ lý” thành hiện thực – và thậm chí còn có thời gian để cười đùa với những lỗi “điên rồ” mà mô hình có thể tạo ra.

Hãy nhớ: AI mạnh mẽ, nhưng con người vẫn là người quyết định cuối cùng. Đừng để bot “đánh bại” bạn trong việc quyết định mua pizza – hãy để nó chỉ gợi ý, còn việc thanh toán thì để bạn nhé!

SEO Keywords

AWS Bedrock, LLM, Retrieval Augmented Generation, RAG, Agentic AI, triển khai AI trên AWS, mô hình ngôn ngữ lớn, fine‑tuning LLM, LangChain, OpenSearch KNN, FAISS, Amazon SageMaker, AI tự động, chi phí AWS AI, hướng dẫn AI chi tiết, AI hài hước, trợ lý AI tự động, tích hợp AI với AWS, công nghệ trí tuệ nhân tạo, phát triển AI trên đám mây.