Bạn đang muốn xây dựng một chatbot thông minh như Jarvis của Iron Man? Hãy cùng khám phá cách tạo ra hệ thống RAG (Retrieval-Augmented Generation) với AWS Bedrock và vector database – công nghệ đang làm “điên đảo” thế giới AI hiện tại!

RAG là gì và tại sao nó “hot” như cháy?

RAG (Retrieval-Augmented Generation) là kỹ thuật kết hợp giữa việc tìm kiếm thông tin và sinh text, giúp chatbot của bạn không chỉ “nói láo” mà còn có căn cứ cụ thể. Thay vì chỉ dựa vào kiến thức được huấn luyện sẵn, RAG cho phép AI “Google” thông tin từ cơ sở dữ liệu của bạn trước khi trả lời.

Tưởng tượng bạn đang thi vấn đáp, thay vì chỉ nhớ những gì học thuộc lòng, bạn được phép tra sách – đó chính là cách RAG hoạt động!

AWS Bedrock – “Siêu anh hùng” của thế giới AI

AWS Bedrock là dịch vụ AI được quản lý hoàn toàn, cung cấp quyền truy cập vào các mô hình ngôn ngữ lớn (LLM) từ Amazon và các đối tác như Anthropic, Cohere. Điểm mạnh của Bedrock:

- Không cần quản lý infrastructure: Bạn chỉ cần gọi API, AWS lo phần còn lại

- Bảo mật cao: Dữ liệu không được sử dụng để huấn luyện mô hình

- Đa dạng mô hình: Claude, Jurassic, Titan – chọn theo sở thích như chọn món ăn

- Serverless: Pay-as-you-use, tiết kiệm hơn cả việc mua trà sữa hàng ngày

Vector Database – “Bộ não” lưu trữ thông tin

Vector database là nơi lưu trữ dữ liệu dưới dạng vector (embedding), cho phép tìm kiếm semantic thay vì chỉ tìm kiếm từ khóa. Các lựa chọn phổ biến:

Amazon OpenSearch Service

Tích hợp sẵn với AWS ecosystem, hỗ trợ k-NN search mạnh mẽ. Phù hợp cho những ai đã “đắm chìm” trong thế giới AWS.

Pinecone

Chuyên dụng cho vector search, dễ sử dụng như “bánh bao chấm tương ớt”. Setup nhanh, hiệu suất cao.

Chroma

Open-source, nhẹ nhàng, phù hợp cho prototype và các dự án nhỏ.

Hướng dẫn xây dựng hệ thống RAG từng bước

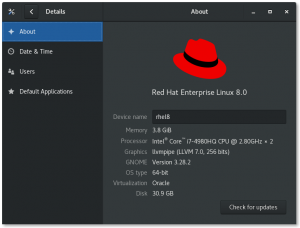

Bước 1: Chuẩn bị môi trường

Đầu tiên, bạn cần setup AWS CLI và các thư viện cần thiết:

pip install boto3 langchain chromadb sentence-transformersĐảm bảo AWS credentials được cấu hình đúng – đây là “chìa khóa vàng” để mở cửa AWS Bedrock.

Bước 2: Tạo embeddings cho dữ liệu

Chuyển đổi documents thành vector embeddings. Bạn có thể sử dụng Amazon Titan Embeddings hoặc các mô hình khác:

Process này giống như việc “dịch” ngôn ngữ con người thành ngôn ngữ máy tính hiểu được. Mỗi câu, đoạn văn sẽ được biến thành một dãy số đại diện cho ý nghĩa.

Bước 3: Lưu trữ vào Vector Database

Upload embeddings vào vector database đã chọn. Với OpenSearch, bạn cần tạo index với mapping phù hợp cho k-NN search. Với Pinecone, chỉ cần gọi API upsert.

Bước 4: Xây dựng Retrieval System

Tạo hệ thống tìm kiếm semantic. Khi user đặt câu hỏi, system sẽ:

- Convert câu hỏi thành embedding

- Tìm kiếm các documents tương tự trong vector database

- Trả về top-k results có độ tương đồng cao nhất

Bước 5: Tích hợp với AWS Bedrock

Sử dụng retrieved context để tạo prompt cho LLM. Cấu trúc prompt quan trọng như “gia vị” trong món ăn – quyết định chatbot của bạn “ngon” hay “dở”.

Một prompt template hiệu quả thường bao gồm:

- System instruction

- Retrieved context

- User question

- Output format specification

Tối ưu hóa hiệu suất hệ thống

Chunking Strategy

Chia nhỏ documents một cách thông minh. Quá nhỏ sẽ mất context, quá lớn sẽ nhiễu thông tin. Sweet spot thường là 200-500 tokens.

Caching

Implement caching cho embeddings và responses phổ biến. Tiền nào của nấy, nhưng cache giúp tiết kiệm cả tiền lẫn thời gian.

Monitoring và Logging

Sử dụng CloudWatch để theo dõi performance. Đặt alerts cho latency cao và error rates – như có “bảo vệ” cho hệ thống của bạn.

Best Practices và lưu ý quan trọng

Để hệ thống RAG hoạt động hiệu quả, cần chú ý:

- Data quality: “Garbage in, garbage out” – dữ liệu chất lượng kém sẽ cho kết quả tệ

- Security: Encrypt data at rest và in transit, sử dụng IAM roles hợp lý

- Cost optimization: Monitor usage, sử dụng reserved capacity khi có thể

- A/B testing: Test các mô hình và parameters khác nhau

Việc triển khai RAG với AWS Bedrock không chỉ giúp tạo ra chatbot thông minh mà còn mở ra cơ hội vô tận cho các ứng dụng AI. Từ customer support đến knowledge management, RAG đang trở thành backbone của nhiều giải pháp AI hiện đại.

Hãy bắt đầu với một prototype đơn giản, sau đó từ từ scale up. Rome không được xây trong một ngày, và chatbot thông minh cũng vậy!

SEO Keywords: RAG system, AWS Bedrock, vector database, chatbot thông minh, Retrieval-Augmented Generation, Amazon OpenSearch, Pinecone, embedding, semantic search, LLM, AI chatbot, machine learning, AWS AI services, natural language processing, intelligent chatbot development