Bạn đang mơ ước tạo ra một chatbot thông minh như Jarvis của Iron Man, nhưng ngân sách chỉ đủ mua bánh mì? Đừng lo! Với LangChain và AWS Bedrock, bạn có thể xây dựng một chatbot ấn tượng mà không cần bán thận. Hãy cùng khám phá hành trình từ zero đến hero trong việc tạo ra chatbot production-ready.

Tại sao chọn LangChain và AWS Bedrock?

Trước khi bắt tay vào code, chúng ta cần hiểu tại sao combo này lại “ngon” đến vậy. LangChain giống như một chiếc cầu nối thần thánh, giúp bạn kết nối các mô hình AI khác nhau một cách dễ dàng. Còn AWS Bedrock? Đó là kho báu chứa đầy các mô hình AI tiên tiến mà bạn có thể sử dụng mà không cần tự train từ đầu – tiết kiệm cả thời gian và tiền bạc!

Thiết lập môi trường phát triển

Đầu tiên, chúng ta cần chuẩn bị “vũ khí” cần thiết:

1. Cài đặt dependencies

Mở terminal và gõ những dòng lệnh thần thánh này:

pip install langchain langchain-aws boto3 streamlit python-dotenvNếu pip báo lỗi, đừng hoảng sợ! Có thể máy bạn đang “ngủ gật” – thử restart terminal và chạy lại.

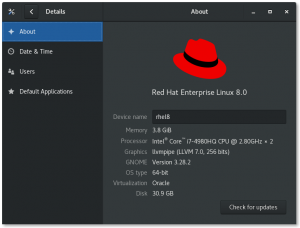

2. Cấu hình AWS credentials

Bạn cần có AWS account và cấu hình credentials. Tạo file .env với nội dung:

AWS_ACCESS_KEY_ID=your_access_key

AWS_SECRET_ACCESS_KEY=your_secret_key

AWS_DEFAULT_REGION=us-east-1Lưu ý: Đừng commit file này lên Git, trừ khi bạn muốn “chia sẻ niềm vui” với toàn thế giới!

Xây dựng chatbot cơ bản

Bước 1: Khởi tạo connection với Bedrock

Tạo file chatbot.py và bắt đầu cuộc phiêu lưu:

from langchain.llms import Bedrock

from langchain.chains import ConversationChain

from langchain.memory import ConversationBufferMemory

import boto3

import os

from dotenv import load_dotenv

load_dotenv()

# Khởi tạo Bedrock client

bedrock_client = boto3.client(

'bedrock-runtime',

region_name=os.getenv('AWS_DEFAULT_REGION'),

aws_access_key_id=os.getenv('AWS_ACCESS_KEY_ID'),

aws_secret_access_key=os.getenv('AWS_SECRET_ACCESS_KEY')

)

# Tạo LLM instance

llm = Bedrock(

client=bedrock_client,

model_id="anthropic.claude-v2",

model_kwargs={"temperature": 0.7, "max_tokens": 1000}

)Bước 2: Thêm memory cho chatbot

Một chatbot không có memory giống như cá vàng – quên ngay sau 3 giây! Chúng ta sẽ thêm bộ nhớ:

# Tạo memory để lưu trữ cuộc hội thoại

memory = ConversationBufferMemory()

# Khởi tạo conversation chain

conversation = ConversationChain(

llm=llm,

memory=memory,

verbose=True

)Bước 3: Tạo giao diện với Streamlit

Streamlit sẽ giúp chúng ta tạo giao diện web đẹp mắt mà không cần CSS phức tạp:

import streamlit as st

def main():

st.title("🤖 Chatbot thông minh với LangChain & AWS Bedrock")

st.write("Xin chào! Tôi là chatbot được tạo bởi sự kết hợp hoàn hảo giữa LangChain và AWS Bedrock!")

# Khởi tạo session state

if "messages" not in st.session_state:

st.session_state.messages = []

# Hiển thị lịch sử chat

for message in st.session_state.messages:

with st.chat_message(message["role"]):

st.markdown(message["content"])

# Input từ user

if prompt := st.chat_input("Hãy nói gì đó..."):

# Thêm message của user

st.session_state.messages.append({"role": "user", "content": prompt})

with st.chat_message("user"):

st.markdown(prompt)

# Tạo response từ chatbot

with st.chat_message("assistant"):

with st.spinner("Đang suy nghĩ..."):

response = conversation.predict(input=prompt)

st.markdown(response)

# Thêm response vào session state

st.session_state.messages.append({"role": "assistant", "content": response})

if __name__ == "__main__":

main()Tối ưu hóa và xử lý lỗi

Trong thực tế, mọi thứ không phải lúc nào cũng suôn sẻ như trong tutorial. Hãy thêm một số cơ chế xử lý lỗi:

import logging

from typing import Optional

logging.basicConfig(level=logging.INFO)

logger = logging.getLogger(__name__)

def safe_predict(conversation_chain, user_input: str) -> Optional[str]:

try:

response = conversation_chain.predict(input=user_input)

return response

except Exception as e:

logger.error(f"Lỗi khi tạo response: {str(e)}")

return "Xin lỗi, tôi đang gặp một chút vấn đề kỹ thuật. Bạn có thể thử lại không?"Triển khai lên Production

Containerization với Docker

Tạo Dockerfile để đóng gói ứng dụng:

FROM python:3.9-slim

WORKDIR /app

COPY requirements.txt .

RUN pip install -r requirements.txt

COPY . .

EXPOSE 8501

CMD ["streamlit", "run", "chatbot.py", "--server.port=8501", "--server.address=0.0.0.0"]Deploy lên AWS ECS hoặc EC2

Bạn có thể deploy chatbot lên AWS ECS để có khả năng scale tự động. Tạo file docker-compose.yml cho việc test local:

version: '3.8'

services:

chatbot:

build: .

ports:

- "8501:8501"

environment:

- AWS_ACCESS_KEY_ID=${AWS_ACCESS_KEY_ID}

- AWS_SECRET_ACCESS_KEY=${AWS_SECRET_ACCESS_KEY}

- AWS_DEFAULT_REGION=${AWS_DEFAULT_REGION}Monitoring và Analytics

Một chatbot production cần có monitoring. Thêm CloudWatch metrics để theo dõi:

- Số lượng requests

- Response time

- Error rate

- Cost theo từng model

Kết luận

Vậy là chúng ta đã hoàn thành hành trình từ zero đến hero! Từ việc setup môi trường đến deploy production, bạn giờ đã có một chatbot hoàn chỉnh. Nhớ rằng, chatbot giống như một đứa trẻ – cần được “dạy dỗ” và cải thiện liên tục.

Đừng quên test kỹ trước khi đưa lên production, và luôn có plan B khi mọi thứ “sập” – vì trong thế giới tech, Murphy’s Law luôn đúng: “Những gì có thể sai thì sẽ sai!”

SEO Keywords: chatbot LangChain, AWS Bedrock tutorial, xây dựng chatbot Python, LangChain Bedrock integration, chatbot production deployment, Streamlit chatbot, AWS AI services, chatbot development guide, LangChain tutorial tiếng Việt, chatbot với AI