Nếu bạn đang xây dựng microservices và mỗi ngày phải đối mặt với hàng triệu request như một người canh gác dũng cảm, thì bài viết này sẽ là bảo kiếm giúp bạn “tạm dừng” những lưu lượng quá tải một cách thông minh. Chúng ta sẽ cùng khám phá cách xây dựng một API Rate Limiter mạnh mẽ bằng Redis và Go, sử dụng thuật toán sliding window – một giải pháp vừa hiệu quả vừa thanh lịch cho hệ thống phân tán hiện đại.

Tại Sao Rate Limiter Quan Trọng Như Chiếc Ô Trong Ngày Mưa?

Hãy tưởng tượng bạn đang điều hành một quán cà phê nhỏ, và đột nhiên có cả một đoàn khách du lịch 100 người ùa vào cùng lúc. Không có cách nào bạn có thể phục vụ tất cả họ ngay lập tức mà không làm ảnh hưởng đến chất lượng dịch vụ cho những khách hàng đã có mặt từ trước.

Tương tự vậy, trong thế giới microservices, rate limiter đóng vai trò như một người phục vụ thông minh, đảm bảo rằng:

- Bảo vệ hệ thống khỏi quá tải: Ngăn chặn những cuộc tấn công DDoS hoặc traffic spikes bất ngờ

- Đảm bảo tính công bằng: Không để một client nào đó “ăn hết bánh” của những người khác

- Kiểm soát chi phí: Hạn chế việc sử dụng tài nguyên một cách bừa bãi

- Duy trì SLA: Đảm bảo response time ổn định cho tất cả người dùng

Sliding Window Algorithm – Chiếc Cửa Sổ Thông Minh

Trong gia đình các thuật toán rate limiting, sliding window là đứa con cưng nhất. Khác với fixed window (cứng nhắc như cái hộp) hay token bucket (phức tạp như máy ATM), sliding window mang lại sự linh hoạt và chính xác đáng kinh ngạc.

Cách Thức Hoạt Động

Sliding window hoạt động như một chiếc cửa sổ di động trên trục thời gian. Thay vì chia thời gian thành những khối cố định, nó liên tục “trượt” theo thời gian thực, đếm số lượng requests trong khoảng thời gian vừa qua.

Ví dụ: Nếu limit là 100 requests/phút, thuật toán sẽ kiểm tra xem trong 60 giây vừa qua có bao nhiêu requests, không phải từ đầu phút hiện tại.

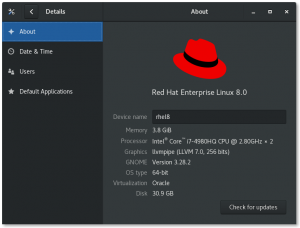

Thiết Kế Kiến Trúc Với Redis và Go

Tại Sao Chọn Redis?

Redis như một siêu thị mini trong RAM – nhanh, tiện lợi và có đầy đủ “đồ chơi” cần thiết:

- Sorted Sets (ZSET): Hoàn hảo cho việc lưu trữ timestamps với điểm số

- Atomic Operations: Đảm bảo tính nhất quán trong môi trường đa luồng

- Lua Scripting: Thực hiện multiple commands như một transaction

- TTL: Tự động dọn dẹp data cũ

Implementation Chi Tiết

1. Cấu Trúc Dữ Liệu

type RateLimiter struct {

client *redis.Client

script *redis.Script

windowSize time.Duration

limit int64

}

2. Lua Script – Trái Tim Của Hệ Thống

Chúng ta sử dụng Lua script để đảm bảo tính atomic nhất có thể. Script này thực hiện 4 bước quan trọng:

local slidingWindowLimiter = `

-- Xóa các entries cũ hơn window

redis.call('ZREMRANGEBYSCORE', KEYS[1], 0, ARGV[1])

-- Đếm số requests hiện tại trong window

local current = redis.call('ZCARD', KEYS[1])

-- Kiểm tra có vượt quá limit không

if current < tonumber(ARGV[3]) then

-- Thêm request mới với timestamp hiện tại

redis.call('ZADD', KEYS[1], ARGV[2], ARGV[4])

redis.call('EXPIRE', KEYS[1], ARGV[5])

return {1, tonumber(ARGV[3]) - current - 1}

else

return {0, 0}

end

`

3. Triển Khai Rate Limiter

func (rl *RateLimiter) Allow(ctx context.Context, key string) (bool, int64, error) {

now := time.Now()

windowStart := now.Add(-rl.windowSize).UnixNano()

result, err := rl.script.Run(ctx, rl.client,

[]string{key},

windowStart,

now.UnixNano(),

rl.limit,

fmt.Sprintf("%d-%d", now.UnixNano(), rand.Int63()),

int(rl.windowSize.Seconds()) + 1,

).Result()

if err != nil {

return false, 0, err

}

values := result.([]interface{})

allowed := values[0].(int64) == 1

remaining := values[1].(int64)

return allowed, remaining, nil

}

Tích Hợp Vào Microservices

Middleware Pattern

Để tích hợp rate limiter vào microservices một cách mượt mà, chúng ta tạo một middleware:

func RateLimitMiddleware(limiter *RateLimiter) gin.HandlerFunc {

return func(c *gin.Context) {

clientID := extractClientID(c)

allowed, remaining, err := limiter.Allow(c.Request.Context(), clientID)

if err != nil {

c.JSON(500, gin.H{"error": "Rate limiter error"})

c.Abort()

return

}

c.Header("X-RateLimit-Remaining", fmt.Sprintf("%d", remaining))

if !allowed {

c.JSON(429, gin.H{

"error": "Rate limit exceeded",

"retry_after": "60",

})

c.Abort()

return

}

c.Next()

}

}

Tối Ưu Hóa Performance

Pipeline Operations

Để giảm latency, có thể sử dụng Redis pipelining cho multiple keys:

func (rl *RateLimiter) AllowBatch(ctx context.Context, keys []string) (map[string]bool, error) {

pipe := rl.client.Pipeline()

results := make(map[string]*redis.Cmd)

for _, key := range keys {

results[key] = pipe.Eval(ctx, rl.script, []string{key}, /* args */)

}

_, err := pipe.Exec(ctx)

// Process results...

}

Memory Optimization

Để tránh memory leak, cần set TTL hợp lý và cleanup định kỳ. Redis đã hỗ trợ auto-expire, nhưng có thể thêm background cleanup job:

func (rl *RateLimiter) cleanup() {

ticker := time.NewTicker(5 * time.Minute)

for range ticker.C {

// Cleanup expired keys

cutoff := time.Now().Add(-2 * rl.windowSize).UnixNano()

rl.client.Eval(context.Background(),

`redis.call('ZREMRANGEBYSCORE', KEYS[1], 0, ARGV[1])`,

[]string{"*"}, cutoff)

}

}

Monitoring và Debugging

Rate limiter cần có khả năng observability tốt:

- Metrics: Track số lượng requests allowed/denied

- Alerts: Cảnh báo khi có traffic bất thường

- Logs: Ghi lại chi tiết các requests bị reject

Xử Lý Edge Cases

Redis Unavailable

Khi Redis down, có thể fallback về in-memory rate limiter hoặc cho phép tất cả requests (tùy theo độ nhạy cảm của hệ thống):

func (rl *RateLimiter) Allow(ctx context.Context, key string) (bool, int64, error) {

allowed, remaining, err := rl.allowWithRedis(ctx, key)

if err != nil {

// Fallback strategy

return rl.fallbackAllow(key), 0, nil

}

return allowed, remaining, nil

}

Best Practices và Lưu Ý

Khi triển khai rate limiter trong production, cần lưu ý:

- Chọn window size phù hợp: Quá nhỏ sẽ không smooth, quá lớn sẽ không responsive

- Xác định client identifier chính xác: IP, User ID, API key, hoặc combination

- Thiết kế rate limits linh hoạt: Khác nhau cho premium/free users

- Cung cấp thông tin rõ ràng: Headers cho client biết remaining quota

- Graceful degradation: Khi rate limiter fail, hệ thống vẫn hoạt động

Kết Luận

Xây dựng rate limiter với sliding window algorithm không chỉ là việc bảo vệ hệ thống, mà còn là nghệ thuật cân bằng giữa hiệu suất và tính sẵn sàng. Implementation với Redis và Go mang lại sự kết hợp hoàn hảo giữa tốc độ, độ tin cậy và khả năng mở rộng.

Như một công cụ đắc lực cho microservices, rate limiter giúp chúng ta ngủ ngon hơn, biết rằng hệ thống được bảo vệ khỏi những traffic storms bất ngờ. Và quan trọng nhất, nó cho phép các service “thở” được trong những lúc cao điểm nhất.

Có thể nói, một rate limiter được thiết kế tốt là như một người bạn tốt – luôn ở đó khi bạn cần, im lặng khi mọi thứ ổn định, và chỉ lên tiếng khi thực sự cần thiết. Đó chính là vẻ đẹp của sliding window algorithm trong thế giới microservices ngày nay.

Để tìm hiểu thêm về các implementation khác nhau của sliding window rate limiter, bạn có thể tham khảo NVIDIA’s go-ratelimit library – một implementation production-ready với nhiều tính năng advance.

SEO Keywords: API rate limiter, Redis sliding window, Go microservices, rate limiting algorithm, Redis ZSET, distributed rate limiter, API throttling, microservices architecture, Go Redis implementation, sliding window counter, API gateway rate limiting, Redis Lua script, traffic control, DDoS protection