Hôm nay chúng ta sẽ cùng nhau khám phá “siêu phẩm” mới nhất từ Nvidia – chip AI H200, một cỗ máy tính toán có thể khiến cho cả ChatGPT cũng phải “gật gù thán phục”. Với hiệu năng vượt trội gần gấp đôi so với thế hệ trước, H200 không chỉ là một bước tiến công nghệ mà còn đánh dấu một giai đoạn hoàn toàn mới trong cuộc đua AI hardware đầy khốc liệt.

Nvidia H200: “Siêu chiến binh” mới trong làng AI

Được Nvidia chính thức ra mắt vào tháng 11/2023 và bắt đầu xuất xưởng trong quý 2 năm 2024, chip H200 không đơn thuần chỉ là một bản nâng cấp – nó giống như việc từ một chiếc xe đạp bỗng nhiên nhảy lên siêu xe Ferrari vậy!

Được xây dựng trên kiến trúc Hopper đình đám, H200 trang bị 141GB bộ nhớ HBM3e với băng thông lên tới 4.8TB/s. Con số này nghe có vẻ khô khan, nhưng hãy tưởng tượng bạn có thể tải xuống toàn bộ thư viện Netflix trong vòng vài giây – đó chính là sức mạnh mà H200 mang lại cho các tác vụ AI.

Hiệu năng “bay bổng” đến mức nào?

Nếu như H100 đã từng khiến cộng đồng tech “điên đảo”, thì H200 chính là phiên bản “siêu saiyan” của người tiền nhiệm. Với khả năng tăng tốc độ inference lên gần gấp đôi cho các mô hình ngôn ngữ lớn như Llama 2, H200 thực sự là một “game changer”.

Cụ thể, chip mới này mang lại:

- Tăng tốc training lên 1.4 lần – Có nghĩa là thời gian huấn luyện một mô hình AI sẽ giảm đáng kể

- Tăng tốc inference lên 1.8 lần – Các ứng dụng AI sẽ phản hồi nhanh hơn, mượt mà hơn

- Cải thiện hiệu suất lên tới 3.4 lần cho các tác vụ đòi hỏi nhiều bộ nhớ

- Tăng 30% CUDA cores so với H100, cùng với công nghệ Tensor Core được cải tiến

Điều thú vị là H200 hoàn toàn tương thích với hệ thống server H100 hiện tại – giống như việc bạn có thể “upgrade” não bộ mà không cần thay đổi toàn bộ cơ thể vậy!

Cuộc chiến AI Hardware: Khi các “đại gia” so găng

Thị trường AI hardware năm 2024 đang trở thành một “trận chiến hoành tráng” với sự cạnh tranh khốc liệt giữa các gã khổng lồ công nghệ. Nvidia tuy vẫn “ngồi mâm trên” với khoảng 80-88% thị phần AI accelerator, nhưng AMD và Intel đang “thở gáy” rất sát nút.

AMD: “Kẻ thách thức” đầy tham vọng

AMD không phải là kẻ “ngồi không” – họ đang tích cực thách thức vị thế của Nvidia với dòng chip Instinct MI325X và MI350. Công ty dự kiến đạt doanh thu 4.5 tỷ USD từ chip AI trong năm 2024, một con số không hề nhỏ trong cuộc đua này.

Chiến lược của AMD khá “thông minh”: mở rộng năng lực sản xuất, hợp tác với các “ông lớn” như Meta, Google, Oracle và Microsoft, đồng thời xây dựng hệ sinh thái phần mềm riêng để “thoát khỏi cái bóng” CUDA của Nvidia.

Intel: “Ông vua” cũ đang “lấy lại ngai vàng”

Intel với chip Gaudi 3 đang thực hiện một chiến lược khá “chất”: thay vì cạnh tranh trực tiếp ở phân khúc high-end, họ tập trung vào inference, edge computing và custom silicon. Đây là nước đi khôn ngoan khi thị trường đang ngày càng đa dạng hóa nhu cầu.

Điều đáng chú ý là Intel đặt mục tiêu xuất xưởng 40 triệu AI PC trong năm 2024 – một con số “khủng” cho thấy tầm nhìn dài hạn của họ trong việc đưa AI đến gần người dùng hơn.

H200 và tương lai của AI

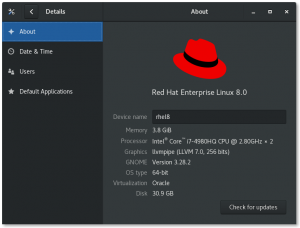

Với H200, Nvidia không chỉ đơn thuần tăng hiệu năng mà còn mở ra nhiều khả năng mới cho AI. Các nhà cung cấp đám mây lớn như Amazon Web Services, Google Cloud và Microsoft Azure đều đã triển khai H200, cho thấy sức hút “không thể cưỡng lại” của siêu chip này.

Điều thú vị nhất có lẽ là H200 có nhiều phiên bản khác nhau (SXM và NVL), mỗi phiên bản được tối ưu cho các kịch bản triển khai cụ thể. Đây chính là minh chứng cho việc AI đang trở nên ngày càng “đa năng” và “linh hoạt”.

Thách thức và cơ hội phía trước

Mặc dù H200 thể hiện sức mạnh “đáng gờm”, nhưng cuộc đua AI hardware vẫn còn nhiều biến số. Các hyperscaler như Google và Amazon đang phát triển chip AI riêng để giảm phụ thuộc vào Nvidia. Thị trường dự kiến sẽ vượt mốc 300 tỷ USD vào năm 2030 – một “cái bánh” đủ lớn cho tất cả “đấu sĩ” tham gia.

Yếu tố địa chính trị cũng đang ảnh hưởng không nhỏ đến ngành này, với các biện pháp kiểm soát xuất khẩu của Mỹ và căng thẳng thương mại Mỹ-Trung đang định hình lại chuỗi cung ứng chip AI toàn cầu.

Kết luận: Nvidia H200 – Bước ngoặt trong cuộc đua AI

H200 không chỉ là một chip – nó là biểu tượng cho một giai đoạn mới trong cuộc cách mạng AI. Với hiệu năng vượt trội và khả năng tương thích linh hoạt, H200 đang mở ra những chân trời mới cho AI, từ các mô hình ngôn ngữ lớn đến ứng dụng thực tế trong đời sống.

Cuộc đua AI hardware đã chính thức bước vào giai đoạn mới – một giai đoạn đầy hứa hẹn nhưng cũng không kém phần khốc liệt. Và trong cuộc đua này, H200 chính là “con ngựa chiến” mà Nvidia đặt cược để tiếp tục dẫn đầu thị trường.

Chỉ có thời gian mới có thể trả lời liệu H200 có thực sự là “game changer” hay chỉ là một bước tiến tạm thời trong cuộc marathon công nghệ này. Nhưng có một điều chắc chắn: tương lai của AI sẽ ngày càng thú vị hơn!

SEO Keywords: Nvidia H200, chip AI, AI hardware, hiệu năng AI chip, Nvidia vs AMD, Intel Gaudi 3, AI accelerator, machine learning chip, CUDA cores, HBM3e memory, AI inference, AI training, chip war, semiconductor AI, Hopper architecture